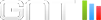

Le navigateur web Opera (ou Opera One) fait la part belle à l'IA et intègre depuis l'année dernière un agent conversationnel Aria basé sur plusieurs grands modèles de langage (LLM). Son utilisation nécessite une connexion à un compte Opera et se base sur le cloud.

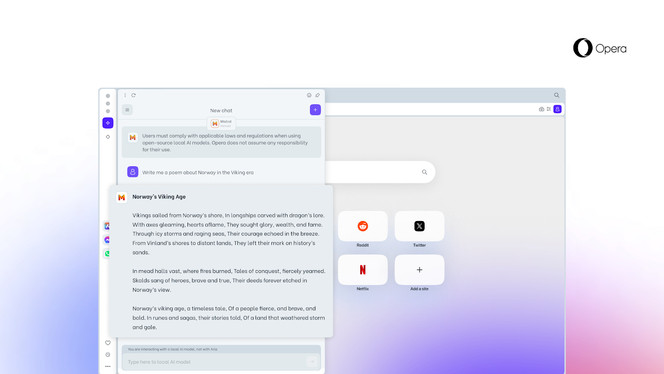

Dans le cadre de la version Opera One Developer pour le moment et d'un programme AI Feature Drop, le navigateur propose désormais d'avoir recours à des modèles d'IA en local. Au choix, c'est une cinquantaine de grands modèles de langage et pour 150 variantes.

Parmi ces LLM en local, Llama de Meta, Gemma de Google ou encore Mixtral de Mistral AI. L'exécution sur l'ordinateur s'appuie sur le framework open source Ollama et à la manière d'une extension du service Aria.

Une première dans un navigateur

" C'est la première fois qu'il est possible d'accéder et de gérer facilement des LLM locaux à partir d'un grand navigateur via une fonctionnalité intégrée. " Opera va tirer parti de cette expérimentation pour explorer davantage les possibilités de modèles d'IA en local.

Évidemment, il faut tenir compte de l'espace de stockage que cela implique et des capacités intrinsèques d'une machine pour obtenir plus ou moins rapidement des résultats d'un LLM en local. Chaque grand modèle de langage en local demande de 2 à 10 Go de stockage.

En pratique, il suffit de lancer Aria, puis de choisir le modèle d'IA en local pour une nouvelle discussion. Le cas échéant, le LLM local est utilisé à la place d'Aria. Une suppression se fait tout aussi simplement qu'un téléchargement.